文章提供:圖文資通組

文章來源:https://www.bnext.com.tw/article/54255/deepfake-solution

AI換臉的偽造影片到處流竄,識別造假的軍備競賽開打

發佈日期:2019/08/06 消息來源:PingWest

2019.08.06 by 品玩 PingWest

如今網路詐騙猖獗,藉由換臉技術行使騙術的狀況層出不窮。各大研究中心紛紛設法防範,但提高鑑假技術的同時,是否也同時提供造假者提升技術的依據?造假與鑑假的攻防戰正如火如荼地展開。

Deepfake自問世以來,一路向著人性陰暗面奔去。

民間技術流已經對AI換臉教程玩得不亦樂乎。但每個人也更容易成為受害者:偽造綁架影片勒索詐騙,不雅影片毀壞名譽,或者恐怖影片製造混亂,都因為Deepfake的開源技術變得空前容易。

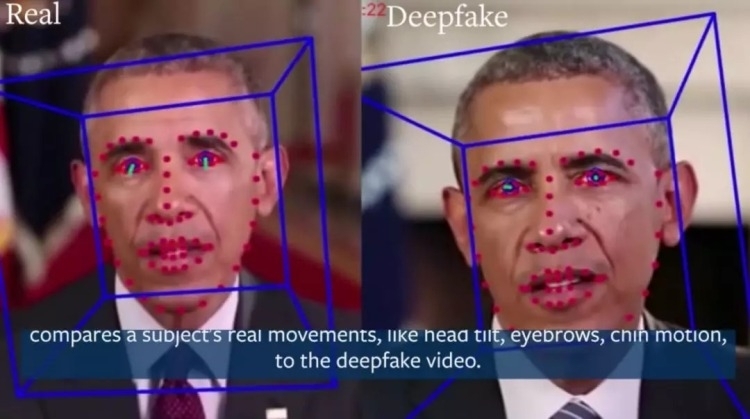

讓一眾名人換上美國前總統布希的面部動作圖TED 圖片來源:品玩

在Photoshop摧毀了大眾對圖片的信任後,Deepfake正在摧毀大眾對影片的信任。沒人想在網路上看到自己的面孔說著自己沒說過的話。許多針對個人的傷害,也因為影響不夠巨大而投訴無門。

美國正在組成一支Deepfake打假隊伍,不僅是各大實驗室、研究中心在尋找Deepfake的破綻,一股創業潮流也正在興起。

但這是一場造假AI與鑑假AI之間「你有張良計,我有過牆梯」的競賽。每一篇檢測Deepfake的論文,彷彿都能提示造假技術修補自身漏洞,從而更上一層樓。

關上Deepfake的潘朵拉魔盒,他們能做到嗎?

用打假Deepfake創業

西瓦.金塔利(Shiva Kintali)離開擔任講師4年的普林斯頓資工系,正在矽谷創業鑑別偽造影片。他的合作對像有警察、記者、保險公司等,透過機器學習尋找偽造影片的破綻,用區塊鏈記錄信息等技術來輔助鑑別。

金塔利的網站已經可以上傳圖像、音樂、影片,來分析檢測是否有修改痕跡。他同時在開發一個手機相機應用程式,用人工智慧為圖像添加時間、地點、浮水印,並將圖片原始信息印在區塊鏈上。一旦傳播圖像的信息與原始圖片不符,就容易判斷真偽。

這些產品希望幫助記者、媒體公司、政治競選團體、執法機構(例如:FBI、NSA),保險公司(面臨虛假事故照片的保險索賠問題)和大公司(例如:Facebook、Twitter、Redditt、Pornhub),在其平台上阻止虛假的影片、音樂、照片傳播。

由於Deepfake降低了影片造假的門檻。面對真偽難辨的影像資料,記者不知道能否發布,保險公司不知是應該理賠還是報警詐騙,警察收集證據後,也需要專業工具去鑑定圖片和影片的真偽。

目前流傳的假影片大多是「淺度造假」,但因為數量多,造成了無數困擾。史丹佛的研究人員向鑑別公司了解到困擾他們的三大問題:數量太多,可用鑑別時間太短,缺乏標準化的工具。

因此,研究者們在尋找能夠大規模應用的打假方法。Facebook、Twitter等社交網絡上爆炸式傳播的圖片和影像,給闢謠留下的時間窗口越來越短。普通大眾也不可能僱傭專業人士進行鑑別。

搶先商用化的圖像驗證平台Truepic已經上線了一款智慧相機應用。用戶拍下的圖像將上傳至服務器,在創建時對照片和影片進行身份驗證,獲得唯一編碼。相機應用捕獲設備的感測器數據,在傳輸之前加密照片或影片,運行20多個圖像取證測試,並在幾秒鐘內,將圖像的加密簽名印在公共區塊鏈上,使得信息不可被篡改。

這是一種「自證清白」的方式,適用於電子商務平台和公民記者類用戶。如果用戶將圖片發送給接收者,Truepic允許收件人驗證圖像的原點和元資料的完整性。任何二次傳播的多媒體材料,都可以與區塊鏈上的原始信息對比,辨別真假。

在Deepfake的威脅下,鑑定圖片、影片的真實性,都成了相機應用的賣點。但這類以營利為目的的產品又引起了用戶新的隱私擔憂。畢竟,誰能確保Truepic不作惡呢?

演算法打演算法

位於矽谷的史丹佛實驗研究院(SRI International)的AI中心則「以毒攻毒」,用偽造的影片訓練演算法,讓演算能夠更好識別出偽造痕跡。在人們上傳影片到社交網站的時候,平台需要對影片重新編碼。這是一個檢測虛假影片的好時機。

但隨著Deepfake的漏洞日漸優化,用演算法打演算法的難度也日益加大。

打假AI原本就是訓練造假AI的一部分,二者剛好在生成對抗性網路的兩端。一個生成器,一個鑑別器,道高一尺,魔高一丈。

由於Deepfake的技術在於篡改數據,那麼鑑別方則在尋找一切篡改數據的痕跡。一種方法是基於像素的影片檢測,影片其實是成千上萬幀圖片連放,細緻到檢測每個像素的改變痕跡,是一件頗為浩大工程。

此外,偽造的面部表情目前仍有缺陷。偽造的臉部表情往往與其他部分存在不一致,電腦演算可以檢測圖片或影片中的這種不一致。

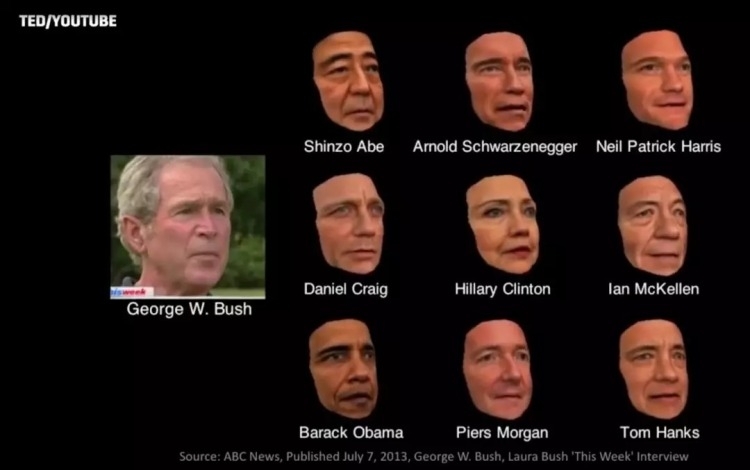

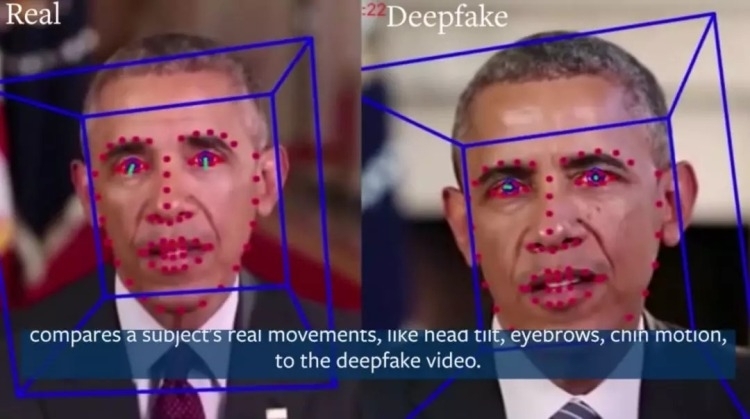

加州大學柏克萊分校的研究者比較真假人物的面部差異 圖片來源:品玩

舉例而言,初代Deepfake影片中的人物,眨眼的方式都有點奇怪。

紐約州立大學奧爾巴尼分校電腦科學系副教授呂思偉曾撰文表示,成年人的眨眼間隔為2秒到10秒,一次眨眼需要十分之一到十分之四秒。這是正常影片人物應有的眨眼頻率,但很多Deepfake影片的人物沒能做到這一點。

彼時由於缺乏閉眼圖像數據,算法的訓練並不完美,影片人物面孔總有一種「哪裡不對」的不和諧感。

然而,通過閉眼的面部圖像、或使用影片序列進行訓練,可以改善眨眼間隔。虛假影片的質量總會提高,而研究人員需要繼續尋找檢測它們漏洞的方法。

南加大的研究者威爾.阿布達-阿爾瑪基德(Wael Abd-Almageed)表示,社群網路可以使用算法來大規模識別Deepfake。為了實現這一過程的自動化,研究人員首先建立了一個神經網絡,「學習」人類在說話時如何移動的重要特徵。然後,研究人員使用這些參數將偽造影片的堆疊幀輸入AI模型,以檢測隨時間的不一致性。

普渡大學的研究人員也採用了類似的方法,他們認為,隨著訓練模型的Deepfake影片數據量越來越大,模型也會更加精確,更容易檢測出偽造的影片。

美國2020年大選在即,如何阻止Deepfake從低俗娛樂發展到操縱民意,是研究者們最迫切的動力之一。但願一鍵打假的速度,能追上一鍵換臉的速度。